Bonjour,

Suite à la mise à jour de mon NAS TS453A et à son non redémarrage automatique j'ai du l'éteindre de manière forcée via le bouton power.

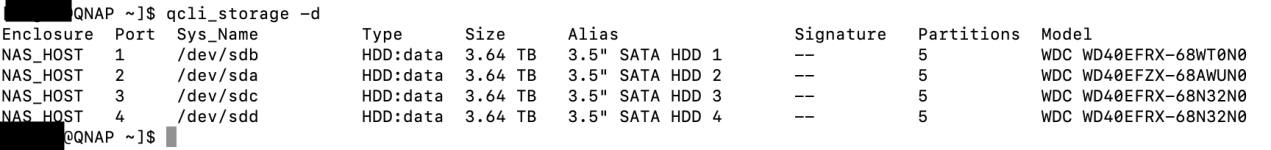

Lorsque le NAS a redémarré il m'a indiqué un problème sur le disque dur 1 qui est à priori celui du système, j'ai fait plusieurs tests rapides qui n'ont pas révélé de panne cependant maintenant il m'indique que des erreurs de lecture/écriture irrécupérables ont été détectées .

.

J'ai tenté de changer le disque à chaud mais le Nas a un peu perdu les pédales car je pense que c'était le disque système, après redémarrage avec le disque 1 originel j'ai pu de nouveau accéder à mes données mais le disque a l'air HS (cf screenshot). Mais j'ai quand même pu lancer une sauvegarde de tout ce que j'avais dessus

(cf screenshot). Mais j'ai quand même pu lancer une sauvegarde de tout ce que j'avais dessus

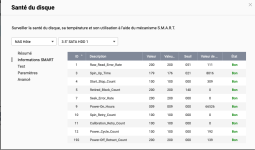

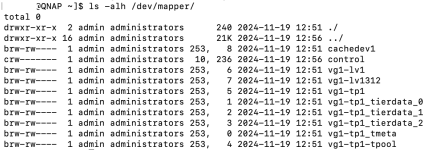

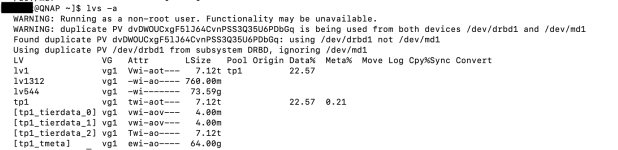

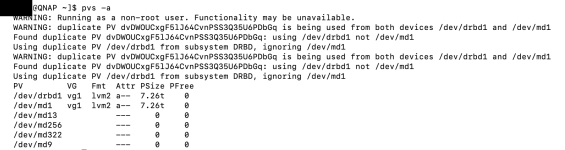

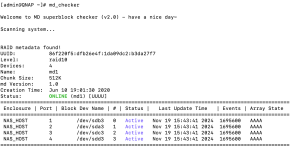

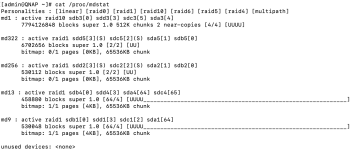

Par ailleurs, le Nas tente désespérément de reconstruire le RAID 10, c'est la 2ème fois que je relance l'opération mais j'ai l'impression que le Pool de stockage n'arrive pas à se remettre dans un état nominal surement à cause du disque 1 (cf capture).

Du coup j'ai plusieurs questions :

D'avance merci pour vos retours !

Aurélien

Suite à la mise à jour de mon NAS TS453A et à son non redémarrage automatique j'ai du l'éteindre de manière forcée via le bouton power.

Lorsque le NAS a redémarré il m'a indiqué un problème sur le disque dur 1 qui est à priori celui du système, j'ai fait plusieurs tests rapides qui n'ont pas révélé de panne cependant maintenant il m'indique que des erreurs de lecture/écriture irrécupérables ont été détectées

J'ai tenté de changer le disque à chaud mais le Nas a un peu perdu les pédales car je pense que c'était le disque système, après redémarrage avec le disque 1 originel j'ai pu de nouveau accéder à mes données mais le disque a l'air HS

Par ailleurs, le Nas tente désespérément de reconstruire le RAID 10, c'est la 2ème fois que je relance l'opération mais j'ai l'impression que le Pool de stockage n'arrive pas à se remettre dans un état nominal surement à cause du disque 1 (cf capture).

Du coup j'ai plusieurs questions :

- Est-ce possible de remettre le système en état en remplaçant le disque 1 si c'est le disque système ou c'est mort ?

- Est-ce possible de s'en tirer s'en avoir à tout réinstaller ?

- Si je dois réinstaller from scratch, quelles est la façon la + simple de procéder : dois-je sortir les disques de leur emplacement et redémarrer le Nas puis réinsérer les disques lorsq'il me le demande ?

D'avance merci pour vos retours !

Aurélien