Hello,

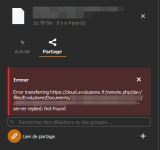

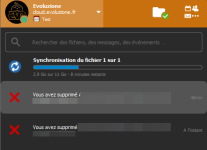

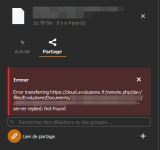

J'ai un soucis avec Nextcloud, il m'est impossible de d'upload un fichier de 11Go. Cela fini en 504 Time-out sur le client Windows, voir Not Found. Via la navigateur, cela va jusqu'au bout, et a la fin

Mon Nextcloud est installé avec l'image de linuxserver.

J'ai augmenté les reglages de mon php-local.ini , sans changement :

et de

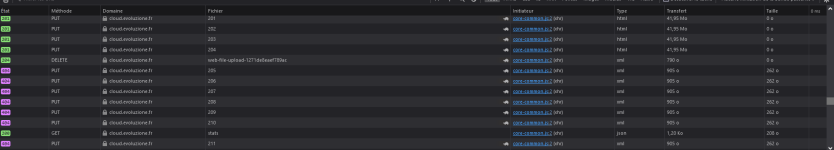

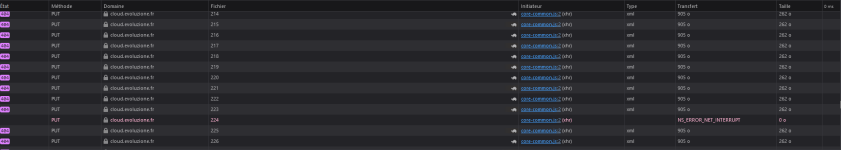

J'ai également essayé de modifier la taille des "morceaux" a 40Mo :

C'est bien pris en compte, car je vois des morceaux de 40Mo dans la console réseau du navigateur. Mais le transfert fini toujours en echec.

Voila, si vous avez des idées

Ps : Les fichiers jusqu’à 7Go ne sont pas un soucis. Entre 7 et 11Go, pas essayé encore.

J'ai un soucis avec Nextcloud, il m'est impossible de d'upload un fichier de 11Go. Cela fini en 504 Time-out sur le client Windows, voir Not Found. Via la navigateur, cela va jusqu'au bout, et a la fin

NS_ERROR_NET_INTERRUPT dans la console, et sur la WebUI le chargement s'arrete, sans aucune erreur visible Mon Nextcloud est installé avec l'image de linuxserver.

J'ai augmenté les reglages de mon php-local.ini , sans changement :

PHP:

; Edit this file to override php.ini directives and restart the container

date.timezone = Europe/Paris

opcache.interned_strings_buffer = 32

opcache.memory_consumption = 256

memory_limit= 20G

upload_max_filesize= 20G

post_max_size= 20G

max_input_time= 6400

max_execution_time= 6400

upload_tmp_dir = /tmp

output_buffering = 0

apc.enable_cli = 1et de

default.conf :

Code:

client_max_body_size 0;

client_body_timeout 6400s;

fastcgi_buffers 64 4K;J'ai également essayé de modifier la taille des "morceaux" a 40Mo :

Code:

occ config:app:set files max_chunk_size --value 41943040C'est bien pris en compte, car je vois des morceaux de 40Mo dans la console réseau du navigateur. Mais le transfert fini toujours en echec.

Voila, si vous avez des idées

Ps : Les fichiers jusqu’à 7Go ne sont pas un soucis. Entre 7 et 11Go, pas essayé encore.