Bonjour, j'ai un Qnap TS-431P. Avec 4x6to en Raid 5. Je m'excuse d'avance si ça va être un peu brouillon en dessous je vais essayer de donner le maximum d'informations par ordre chronologique sur mon soucis.

Semaine dernière alerte SMART de mon disque n°4 avec erreurs d'écriture. Volume toujours dispo en marche dégradé, j'éteins le NAS proprement je remplace le disque 4 par un disque de secours (un WD purple neuf) je relance le nas, la re-construction du raid commence automatiquement, jusque la pas de soucis.

Vers la fin de la reconstruction : Erreur moyenne HDD 3 et le 4 bascule en erreur "E/S de l'historique d'accès au disque" alors que le smart est OK. Le 3 lui est en jaune en avertissement secteur défectueux SMART. La reconstruction n'a pas fonctionné, le volume est toujours dispo en "lecture seule".

Comme pour reconstruire le raid il faut à Qnap 3 disques durs avec SMART ok, j'ai sorti le disque 3, je l'ai passé en "scan et repair" sur le logiciel HDD regénérator et la miracle, mon HDD 3 reviens avec un smart OK (15 secteurs réparés).

Du coup me revoilà sur mon NAS avec mes HDD 1,2,3 en vert et mon raid 5 en marche dégradé avec lecture/écriture autorisé.

(Je suis 100% conscient qu'après reconstruction sur le disque 4, il faudra remplacer rapidement le 3)

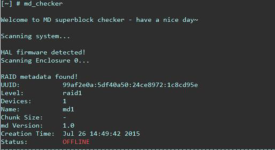

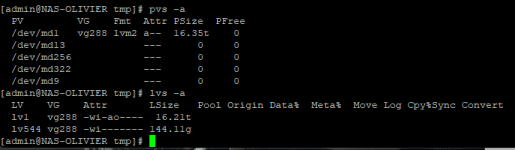

Mais le soucis maintenant c'est mon disque neuf... après l'échec de la reconstruction je l'ai passé sous crystal disk info RAS, J'ai fait un scan minutieux de tout les secteurs sur HDTunePro, RAS, un scan complet via l'interface Qnap en espérant qu'il m’acquitte le défaut mais c'est toujours pareil, le scan des secteur c'est bien passé mais toujours le message d'erreur "E/S de l'historique d'accès au disque" . J'ai finalement réussi à enlever le défaut via une formule trouvé sur reddit via ssh " sudo sed -i '/pd_err_wwn_/d' /mnt/HDA_ROOT/.conf"

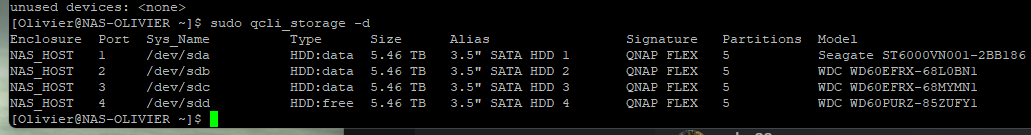

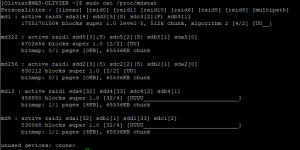

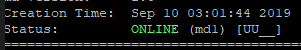

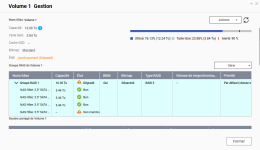

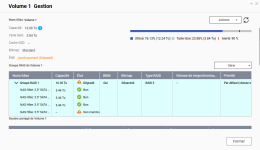

Et nous voila donc aujourd'hui, avec mes 4 disques en vert. Les 3 premiers avec le contenu de mon raid 5 en marche dégradé, et le 4e neuf en vert aussi, smart OK. Marqué comme "non membre"

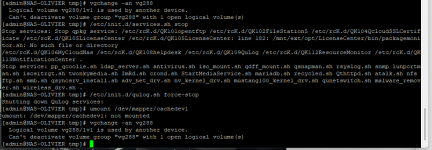

Sauf qu'il m'est impossible de reconstruire le raid dessus car le NAS me marque " Le disque installé ne convient pas a la reconstruction du groupe RAID 1. Installez un autre disque pour reconstruire le groupe RAID."

Depuis je sèche... J'ai ressorti le disque 4, je l'ai formaté complet et j'ai effacé toutes les partitions via diskpart > clean . Toujours le même message quand je le remets dans le NAS.

Voici quelques captures d'écran :

J'estime que j'ai déjà beaucoup de chance d'avoir encore accès à mes données, je vais arrêter de tenter le diable et je m'en remets à vous

Merci d'avance.

Semaine dernière alerte SMART de mon disque n°4 avec erreurs d'écriture. Volume toujours dispo en marche dégradé, j'éteins le NAS proprement je remplace le disque 4 par un disque de secours (un WD purple neuf) je relance le nas, la re-construction du raid commence automatiquement, jusque la pas de soucis.

Vers la fin de la reconstruction : Erreur moyenne HDD 3 et le 4 bascule en erreur "E/S de l'historique d'accès au disque" alors que le smart est OK. Le 3 lui est en jaune en avertissement secteur défectueux SMART. La reconstruction n'a pas fonctionné, le volume est toujours dispo en "lecture seule".

Comme pour reconstruire le raid il faut à Qnap 3 disques durs avec SMART ok, j'ai sorti le disque 3, je l'ai passé en "scan et repair" sur le logiciel HDD regénérator et la miracle, mon HDD 3 reviens avec un smart OK (15 secteurs réparés).

Du coup me revoilà sur mon NAS avec mes HDD 1,2,3 en vert et mon raid 5 en marche dégradé avec lecture/écriture autorisé.

(Je suis 100% conscient qu'après reconstruction sur le disque 4, il faudra remplacer rapidement le 3)

Mais le soucis maintenant c'est mon disque neuf... après l'échec de la reconstruction je l'ai passé sous crystal disk info RAS, J'ai fait un scan minutieux de tout les secteurs sur HDTunePro, RAS, un scan complet via l'interface Qnap en espérant qu'il m’acquitte le défaut mais c'est toujours pareil, le scan des secteur c'est bien passé mais toujours le message d'erreur "E/S de l'historique d'accès au disque" . J'ai finalement réussi à enlever le défaut via une formule trouvé sur reddit via ssh " sudo sed -i '/pd_err_wwn_/d' /mnt/HDA_ROOT/.conf"

Et nous voila donc aujourd'hui, avec mes 4 disques en vert. Les 3 premiers avec le contenu de mon raid 5 en marche dégradé, et le 4e neuf en vert aussi, smart OK. Marqué comme "non membre"

Sauf qu'il m'est impossible de reconstruire le raid dessus car le NAS me marque " Le disque installé ne convient pas a la reconstruction du groupe RAID 1. Installez un autre disque pour reconstruire le groupe RAID."

Depuis je sèche... J'ai ressorti le disque 4, je l'ai formaté complet et j'ai effacé toutes les partitions via diskpart > clean . Toujours le même message quand je le remets dans le NAS.

Voici quelques captures d'écran :

J'estime que j'ai déjà beaucoup de chance d'avoir encore accès à mes données, je vais arrêter de tenter le diable et je m'en remets à vous

Merci d'avance.